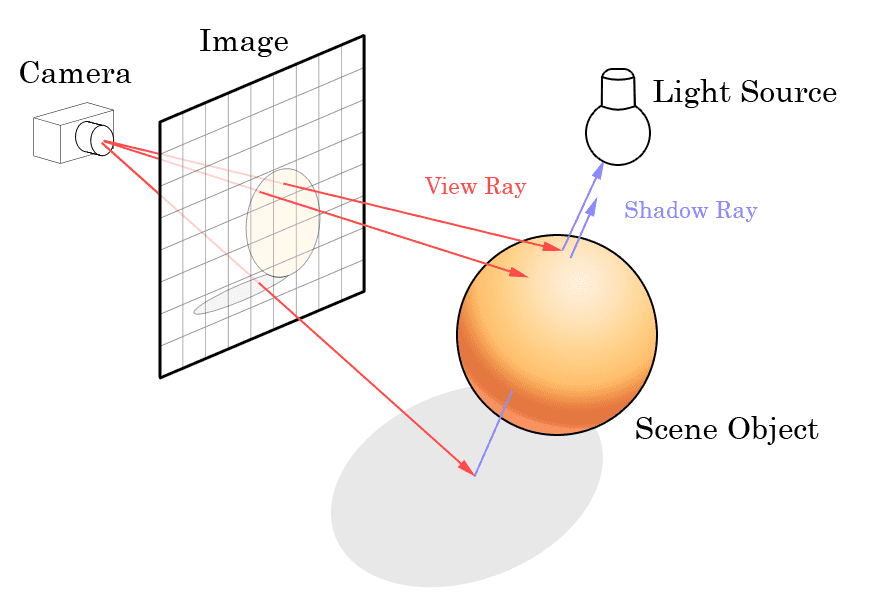

Raytracing ist eine Technologie, die den Weg des Gesichtsfeldes berechnet und den Reflektor und die entsprechende Lichtquelle findet, um den Lichteffekt zu simulieren.

Wenn in der realen Welt Licht auf ein Objekt fällt, wird ein Teil des Lichts absorbiert, ein Teil reflektiert und ein Teil vom Auge gesehen, und die Anwesenheit des Objekts wird erkannt, wenn das vom Objekt und seiner Umgebung reflektierte Licht reflektiert wird durch die Brille beobachtet.

Und Raytracing besteht darin, die „Linse“ des Bildschirms als menschliches Auge darzustellen, unsichtbares Licht abzufeuern, um das Objekt auf dem Bildschirm freizugeben, und dann zu berechnen, ob es mit der Lichtquelle auf dem Bildschirm übereinstimmen kann, und entsprechend der berechneten Lichthelligkeit Bildschirm anzuzeigen.

Dieses Technologiekonzept wurde ursprünglich 1969 vom IBM-Mitarbeiter Arthur Appel als Prototyp vorgeschlagen und 1979 von Turner Whitted in der konkreten Umsetzung der Idee und der Art und Weise perfektioniert.

Das Aufkommen von Raytracing ermöglicht es, Licht im Bild zu simulieren, ohne das globale Licht zu berechnen. Es muss lediglich der Teil des Auges berechnet werden, in dem der Inhalt angezeigt wird, und dann berechnet werden, wodurch gleichzeitig die zum Rendern des Bildes erforderlichen Ressourcen erheblich reduziert werden Lichtstärke.

Vor der Implementierung der Echtzeit-Raytracing-Technologie auf PC-Grafikkarten müssen Spiele die Lichtleistung simulieren, um die Wirkung des Spiels zu verbessern. Die Leistung des Computers kann jedoch die Menge an Lichtberechnungen nicht unterstützen. Spieleentwickler haben sich eine Vielzahl davon ausgedacht Möglichkeiten, so viel wie möglich im Spiel zu simulieren, um den Lichteffekt überzeugend zu machen.

Bereits in der FPS-Pionierarbeit von „Doom“ wurde die Feuersimulation für schießende Kugeln eingeführt, diese ist jedoch immer noch sehr elementar im Körper des Feindes außerhalb des Feuers und die Szene hat keine weitere Simulation durchgeführt. Nach der Generation des Klassikers „Half-Life 2“, der mehr Szenenbeleuchtungsberechnungen einführt, kann jeder Angriff die Veränderung von Licht und Schatten spüren, die zum Zeitpunkt der durch den Lichteffekt verursachten Schattenänderungen berechnet wird, auch die Szene Es fehlt mehr Lichtberechnung.

Danach fanden die Entwickler einen sparsameren, aber besseren Ansatz: Pre-Rendering. Bei der Produktion wird jede Karte auf dem Spielbildschirm angezeigt. Je nach Bedarf wird die entsprechende Lichtleistung entsprechend dem Bildschirm vorberechnet. Um das Spiel auszuführen, wird die entsprechende Karte direkt geladen und dann eine kleine Lichtmenge in Echtzeit berechnet. man kann damit einen recht guten Effekt erzielen.

Manche Leute fragen sich vielleicht, warum derselbe Computer das Bild berechnet, warum die Filmeffekte, insbesondere in Science-Fiction-Filmen, eine realistischere Lichtleistung haben können? Weil sie zuerst Raytracing verwendet haben. Ja, vor einigen Jahren hat die Filmindustrie im Personalcomputer mit Raytracing die Raytracing-Technologie eingeführt, um die Lichtleistung des Bildes zu verbessern.

Anstelle der intensiven Anforderung, 30 oder sogar 60 Bilder pro Sekunde zu rendern, könnte es mehrere zehn Minuten oder sogar Stunden dauern, bis Filmbilder in einer Gruppe leistungsstarker Computer nur ein Bild rendern und so Lichteffekte erzielen, die mit der realen Welt vergleichbar sind.

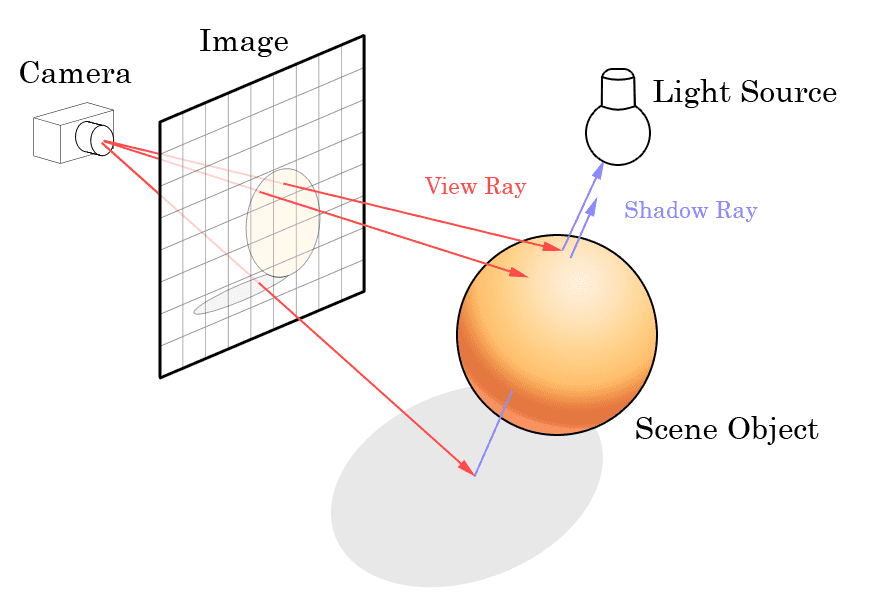

Wenn in der realen Welt Licht auf ein Objekt fällt, wird ein Teil des Lichts absorbiert, ein Teil reflektiert und ein Teil vom Auge gesehen, und die Anwesenheit des Objekts wird erkannt, wenn das vom Objekt und seiner Umgebung reflektierte Licht reflektiert wird durch die Brille beobachtet.

Wenn in der realen Welt Licht auf ein Objekt fällt, wird ein Teil des Lichts absorbiert, ein Teil reflektiert und ein Teil vom Auge gesehen, und die Anwesenheit des Objekts wird erkannt, wenn das vom Objekt und seiner Umgebung reflektierte Licht reflektiert wird durch die Brille beobachtet.

Und Raytracing besteht darin, die „Linse“ des Bildschirms als menschliches Auge darzustellen, unsichtbares Licht abzufeuern, um das Objekt auf dem Bildschirm freizugeben, und dann zu berechnen, ob es mit der Lichtquelle auf dem Bildschirm übereinstimmen kann, und entsprechend der berechneten Lichthelligkeit Bildschirm anzuzeigen.

Und Raytracing besteht darin, die „Linse“ des Bildschirms als menschliches Auge darzustellen, unsichtbares Licht abzufeuern, um das Objekt auf dem Bildschirm freizugeben, und dann zu berechnen, ob es mit der Lichtquelle auf dem Bildschirm übereinstimmen kann, und entsprechend der berechneten Lichthelligkeit Bildschirm anzuzeigen.

Dieses Technologiekonzept wurde ursprünglich 1969 vom IBM-Mitarbeiter Arthur Appel als Prototyp vorgeschlagen und 1979 von Turner Whitted in der konkreten Umsetzung der Idee und der Art und Weise perfektioniert.

Das Aufkommen von Raytracing ermöglicht es, Licht im Bild zu simulieren, ohne das globale Licht zu berechnen. Es muss lediglich der Teil des Auges berechnet werden, in dem der Inhalt angezeigt wird, und dann berechnet werden, wodurch gleichzeitig die zum Rendern des Bildes erforderlichen Ressourcen erheblich reduziert werden Lichtstärke.

Dieses Technologiekonzept wurde ursprünglich 1969 vom IBM-Mitarbeiter Arthur Appel als Prototyp vorgeschlagen und 1979 von Turner Whitted in der konkreten Umsetzung der Idee und der Art und Weise perfektioniert.

Das Aufkommen von Raytracing ermöglicht es, Licht im Bild zu simulieren, ohne das globale Licht zu berechnen. Es muss lediglich der Teil des Auges berechnet werden, in dem der Inhalt angezeigt wird, und dann berechnet werden, wodurch gleichzeitig die zum Rendern des Bildes erforderlichen Ressourcen erheblich reduziert werden Lichtstärke.

Vor der Implementierung der Echtzeit-Raytracing-Technologie auf PC-Grafikkarten müssen Spiele die Lichtleistung simulieren, um die Wirkung des Spiels zu verbessern. Die Leistung des Computers kann jedoch die Menge an Lichtberechnungen nicht unterstützen. Spieleentwickler haben sich eine Vielzahl davon ausgedacht Möglichkeiten, so viel wie möglich im Spiel zu simulieren, um den Lichteffekt überzeugend zu machen.

Vor der Implementierung der Echtzeit-Raytracing-Technologie auf PC-Grafikkarten müssen Spiele die Lichtleistung simulieren, um die Wirkung des Spiels zu verbessern. Die Leistung des Computers kann jedoch die Menge an Lichtberechnungen nicht unterstützen. Spieleentwickler haben sich eine Vielzahl davon ausgedacht Möglichkeiten, so viel wie möglich im Spiel zu simulieren, um den Lichteffekt überzeugend zu machen.

Bereits in der FPS-Pionierarbeit von „Doom“ wurde die Feuersimulation für schießende Kugeln eingeführt, diese ist jedoch immer noch sehr elementar im Körper des Feindes außerhalb des Feuers und die Szene hat keine weitere Simulation durchgeführt. Nach der Generation des Klassikers „Half-Life 2“, der mehr Szenenbeleuchtungsberechnungen einführt, kann jeder Angriff die Veränderung von Licht und Schatten spüren, die zum Zeitpunkt der durch den Lichteffekt verursachten Schattenänderungen berechnet wird, auch die Szene Es fehlt mehr Lichtberechnung.

Bereits in der FPS-Pionierarbeit von „Doom“ wurde die Feuersimulation für schießende Kugeln eingeführt, diese ist jedoch immer noch sehr elementar im Körper des Feindes außerhalb des Feuers und die Szene hat keine weitere Simulation durchgeführt. Nach der Generation des Klassikers „Half-Life 2“, der mehr Szenenbeleuchtungsberechnungen einführt, kann jeder Angriff die Veränderung von Licht und Schatten spüren, die zum Zeitpunkt der durch den Lichteffekt verursachten Schattenänderungen berechnet wird, auch die Szene Es fehlt mehr Lichtberechnung.

Danach fanden die Entwickler einen sparsameren, aber besseren Ansatz: Pre-Rendering. Bei der Produktion wird jede Karte auf dem Spielbildschirm angezeigt. Je nach Bedarf wird die entsprechende Lichtleistung entsprechend dem Bildschirm vorberechnet. Um das Spiel auszuführen, wird die entsprechende Karte direkt geladen und dann eine kleine Lichtmenge in Echtzeit berechnet. man kann damit einen recht guten Effekt erzielen.

Danach fanden die Entwickler einen sparsameren, aber besseren Ansatz: Pre-Rendering. Bei der Produktion wird jede Karte auf dem Spielbildschirm angezeigt. Je nach Bedarf wird die entsprechende Lichtleistung entsprechend dem Bildschirm vorberechnet. Um das Spiel auszuführen, wird die entsprechende Karte direkt geladen und dann eine kleine Lichtmenge in Echtzeit berechnet. man kann damit einen recht guten Effekt erzielen.

Manche Leute fragen sich vielleicht, warum derselbe Computer das Bild berechnet, warum die Filmeffekte, insbesondere in Science-Fiction-Filmen, eine realistischere Lichtleistung haben können? Weil sie zuerst Raytracing verwendet haben. Ja, vor einigen Jahren hat die Filmindustrie im Personalcomputer mit Raytracing die Raytracing-Technologie eingeführt, um die Lichtleistung des Bildes zu verbessern.

Manche Leute fragen sich vielleicht, warum derselbe Computer das Bild berechnet, warum die Filmeffekte, insbesondere in Science-Fiction-Filmen, eine realistischere Lichtleistung haben können? Weil sie zuerst Raytracing verwendet haben. Ja, vor einigen Jahren hat die Filmindustrie im Personalcomputer mit Raytracing die Raytracing-Technologie eingeführt, um die Lichtleistung des Bildes zu verbessern.

Anstelle der intensiven Anforderung, 30 oder sogar 60 Bilder pro Sekunde zu rendern, könnte es mehrere zehn Minuten oder sogar Stunden dauern, bis Filmbilder in einer Gruppe leistungsstarker Computer nur ein Bild rendern und so Lichteffekte erzielen, die mit der realen Welt vergleichbar sind.

Anstelle der intensiven Anforderung, 30 oder sogar 60 Bilder pro Sekunde zu rendern, könnte es mehrere zehn Minuten oder sogar Stunden dauern, bis Filmbilder in einer Gruppe leistungsstarker Computer nur ein Bild rendern und so Lichteffekte erzielen, die mit der realen Welt vergleichbar sind.